- 作者:老汪软件技巧

- 发表时间:2024-09-15 00:02

- 浏览量:164

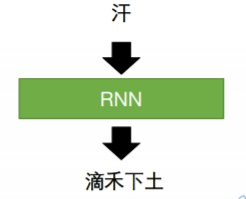

深入解析循环神经网络(RNN)

循环神经网络(RNN)是处理序列数据的一种强大工具,广泛应用于自然语言处理、时间序列预测等领域。本文将深入探讨 RNN的优势、使用场景、项目案例及其代码实现。

一、RNN 的优势

处理序列数据:RNN 通过其循环结构,能够有效地处理和记忆序列数据中的时间依赖关系,适合于任意长度的输入序列。

共享权重:RNN 在时间维度上共享权重,显著减少了模型参数的数量,有助于提高训练效率。

动态输入长度:RNN 可以接收可变长度的输入序列,适用于许多实际应用中常见的非定长问题。

上下文信息捕捉:RNN 具有记忆能力,可以根据序列中的上下文信息生成更为准确的输出。

二、使用场景

自然语言处理:

时间序列分析:

语音识别:

视频分析:

三、项目案例1. 机器翻译

项目描述:构建一个基于 RNN 的机器翻译模型,将英文句子翻译为法文。

实现:

2. 股票价格预测

项目描述:使用 RNN 预测未来股票价格。

实现:

四、代码实现

以下是一个简单的 RNN 实现,用于序列预测。我们将使用 Python 和 Keras 库。

4.1 环境设置

确保你已安装必要的库:

pip install numpy pandas keras tensorflow

4.2 数据准备

我们将生成简单的时间序列数据作为示例:

import numpy as np

import pandas as pd

# 生成时间序列数据

def generate_data(seq_length, num_samples):

X = []

y = []

for _ in range(num_samples):

start = np.random.rand() * 10

seq = [start + i for i in range(seq_length)]

X.append(seq[:-1]) # 输入是前面的值

y.append(seq[1:]) # 输出是后面的值

return np.array(X), np.array(y)

X, y = generate_data(seq_length=10, num_samples=1000)

X = X.reshape((X.shape[0], X.shape[1], 1)) # 形状调整为 (样本数, 时间步, 特征数)

4.3 构建 RNN 模型

from keras.models import Sequential

from keras.layers import SimpleRNN, Dense

# 构建 RNN 模型

model = Sequential()

model.add(SimpleRNN(50, activation='relu', input_shape=(X.shape[1], 1)))

model.add(Dense(1)) # 输出层

model.compile(optimizer='adam', loss='mean_squared_error')

4.4 模型训练

# 训练模型

model.fit(X, y, epochs=100, batch_size=32)

4.5 进行预测

# 进行预测

test_seq = np.array([0, 1, 2, 3, 4, 5, 6, 7, 8]).reshape((1, 9, 1))

predicted = model.predict(test_seq)

print(predicted)

五、循环神经网络(RNN)完整 Demo 代码

以下是一个完整的 RNN 实现示例,用于时间序列预测。我们将使用 Keras 和 TensorFlow 库,构建一个简单的 RNN 模型来预测未来的值。这个示例将涵盖数据生成、模型构建、训练和预测的完整流程。

5.1 环境设置

确保你已经安装了必要的库:

pip install numpy pandas matplotlib keras tensorflow

5.2 代码实现5.2.1 导入库

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from keras.models import Sequential

from keras.layers import SimpleRNN, Dense

5.2.2 数据生成

我们将生成一个简单的正弦波数据集作为示例,以模拟时间序列数据。

# 生成时间序列数据

def generate_sine_wave(seq_length, num_samples):

X = []

y = []

for _ in range(num_samples):

start = np.random.rand() * 2 * np.pi # 随机起始点

seq = [np.sin(start + i * 0.1) for i in range(seq_length + 1)] # 正弦波

X.append(seq[:-1]) # 输入是前面的值

y.append(seq[1:]) # 输出是后面的值

return np.array(X), np.array(y)

# 生成数据

X, y = generate_sine_wave(seq_length=50, num_samples=1000)

X = X.reshape((X.shape[0], X.shape[1], 1)) # 形状调整为 (样本数, 时间步, 特征数)

5.2.3 划分训练集和测试集

# 划分训练集和测试集

train_size = int(len(X) * 0.8)

X_train, X_test = X[:train_size], X[train_size:]

y_train, y_test = y[:train_size], y[train_size:]

5.2.4 构建 RNN 模型

# 构建 RNN 模型

model = Sequential()

model.add(SimpleRNN(50, activation='relu', input_shape=(X_train.shape[1], 1)))

model.add(Dense(1)) # 输出层

model.compile(optimizer='adam', loss='mean_squared_error')

5.2.5 模型训练

# 训练模型

history = model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_test, y_test))

5.2.6 绘制训练过程中的损失曲线

# 绘制损失曲线

plt.plot(history.history['loss'], label='train loss')

plt.plot(history.history['val_loss'], label='val loss')

plt.title('Model Loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend()

plt.show()

5.2.7 进行预测

# 进行预测

predicted = model.predict(X_test)

# 绘制预测结果

plt.figure(figsize=(12, 6))

plt.plot(y_test.flatten(), label='True Values')

plt.plot(predicted.flatten(), label='Predicted Values')

plt.title('True vs Predicted Values')

plt.ylabel('Value')

plt.xlabel('Time Step')

plt.legend()

plt.show()

5.3 完整代码

以下是上述所有代码的整合,形成完整的 RNN Demo:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from keras.models import Sequential

from keras.layers import SimpleRNN, Dense

# 生成时间序列数据

def generate_sine_wave(seq_length, num_samples):

X = []

y = []

for _ in range(num_samples):

start = np.random.rand() * 2 * np.pi # 随机起始点

seq = [np.sin(start + i * 0.1) for i in range(seq_length + 1)] # 正弦波

X.append(seq[:-1]) # 输入是前面的值

y.append(seq[1:]) # 输出是后面的值

return np.array(X), np.array(y)

# 生成数据

X, y = generate_sine_wave(seq_length=50, num_samples=1000)

X = X.reshape((X.shape[0], X.shape[1], 1)) # 形状调整为 (样本数, 时间步, 特征数)

# 划分训练集和测试集

train_size = int(len(X) * 0.8)

X_train, X_test = X[:train_size], X[train_size:]

y_train, y_test = y[:train_size], y[train_size:]

# 构建 RNN 模型

model = Sequential()

model.add(SimpleRNN(50, activation='relu', input_shape=(X_train.shape[1], 1)))

model.add(Dense(1)) # 输出层

model.compile(optimizer='adam', loss='mean_squared_error')

# 训练模型

history = model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_test, y_test))

# 绘制损失曲线

plt.plot(history.history['loss'], label='train loss')

plt.plot(history.history['val_loss'], label='val loss')

plt.title('Model Loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend()

plt.show()

# 进行预测

predicted = model.predict(X_test)

# 绘制预测结果

plt.figure(figsize=(12, 6))

plt.plot(y_test.flatten(), label='True Values')

plt.plot(predicted.flatten(), label='Predicted Values')

plt.title('True vs Predicted Values')

plt.ylabel('Value')

plt.xlabel('Time Step')

plt.legend()

plt.show()

5.4 示例总结

通过这个完整的 RNN Demo,我们展示了如何生成时间序列数据、构建和训练 RNN 模型以及进行预测。该示例可以扩展到更复杂的应用,如自然语言处理和其他时间序列任务。RNN 在处理序列数据时表现出色,尽管存在一些局限性,但通过使用 LSTM 或 GRU 等变种可以克服许多挑战。

六、总结

循环神经网络(RNN)凭借其优越的时间序列处理能力,广泛应用于自然语言处理、金融预测等领域。尽管 RNN存在一些局限性(如梯度消失),但通过 LSTM 和 GRU 等变种,这些问题得到了有效解决。通过实际案例和代码示例,我们可以看到 RNN的强大潜力与应用价值。