- 作者:老汪软件技巧

- 发表时间:2024-12-21 10:07

- 浏览量:

吴恩达老师最近在 deeplearning.ai 网站上发表了一篇名为 《放眼未来,回顾过去》 的文章。在这篇充满前瞻性与思辨的文章中,吴恩达回顾了自己在深度学习领域的历史性贡献,以及一些曾经被质疑却最终证明正确的决策。他讲述了如何凭借对AI技术扩展的坚定信念,引领团队迈出了划时代的一步,并分享了关于未来AI发展的深刻洞察。对所有关心人工智能、深度学习进展的人来说,这篇文章无疑是一剂思想的良药,值得细细品读。

TL;DR原文翻译

我非常高兴我的前学生和博士后们获得了今年NeurIPS的“时间检验论文奖”。该奖项旨在表彰十年前发表的、对研究领域产生重大影响的论文。获奖者包括Ian Goodfellow(他在本科期间就在宿舍里为我搭建了第一台用于深度学习的GPU服务器)及其合作者,他们的工作关于生成对抗网络(GAN),以及我的前博士后Ilya Sutskever和博士生Quoc Le(与Oriol Vinyals合作),他们的工作关于序列到序列(SEQ2SEQ)学习。祝贺所有这些获奖者!

本质上,我更倾向于关注未来而非过去。史蒂夫·乔布斯拒绝建立一个企业博物馆,而是将苹果的档案捐赠给斯坦福大学,因为他希望公司始终保持前瞻性。杰夫·贝佐斯鼓励团队以“Day 1”的心态对待每一天,这种心态强调保持公司或行业处于早期创新阶段。这些理念与我很共鸣。

但短暂回顾过去可以帮助我们反思未来的经验教训。从回顾十年到十五年前的成功经验中,我得出的一个结论是:我所领导的许多团队都大力押注于通过扩展来推动AI进步——这一押注为构建越来越大的 AI 系统奠定了基础。但在当时,扩大神经网络规模的想法颇具争议,是非主流的。我清晰地记得,大约在2008年,Yoshua Bengio(与 Geoffrey Hinton 和 Yann LeCun 并成为深度学习三巨头)建议我不要押注于扩展,而是专注于发明算法!

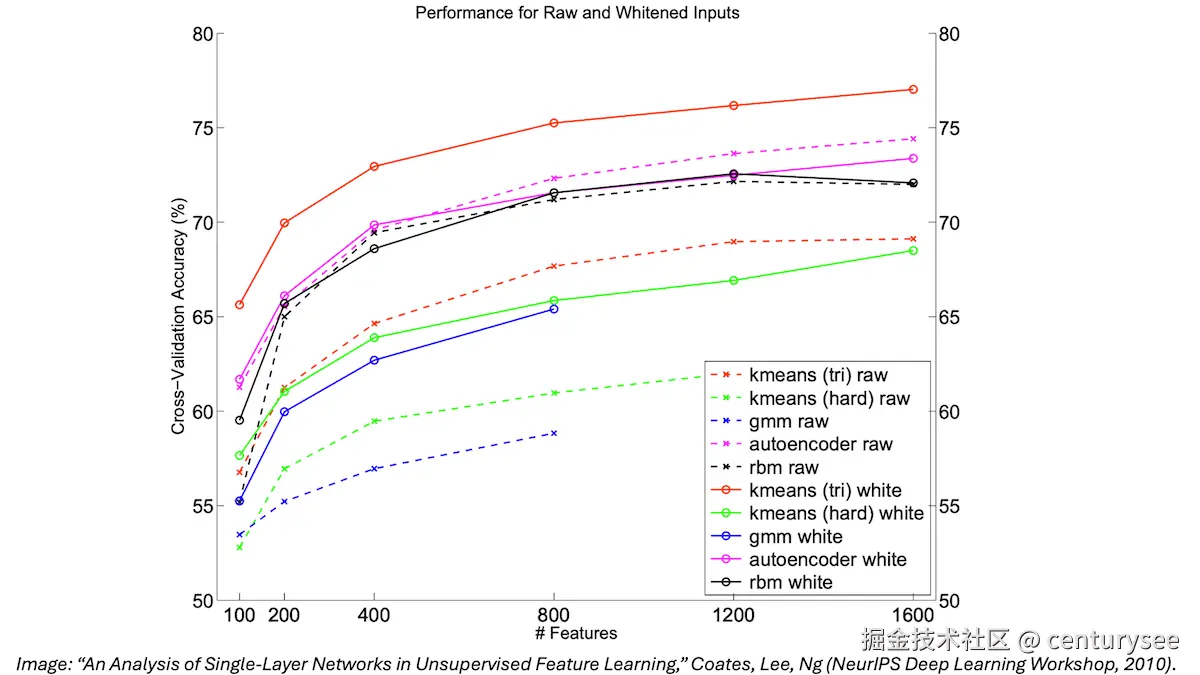

我从那时学到的一个教训是,不要在意他人的看法,而是要追随自己的信念,尤其是当你有数据支持你的信念时。我所在的斯坦福团队进行的小规模实验让我确信,扩大神经网络规模将推动显著进步,这也是我愿意忽略怀疑者的理由。下面这张由Adam Coates和Honglak Lee生成的图表,是当时最坚定我信念的依据。它显示,对于一系列模型,我们越扩大它们的规模,它们的性能就越好。我记得在2010年的CIFAR会议上展示了这张图,如果非要选一个原因来解释我为什么坚持推动成立Google Brain并将扩展深度学习算法设为团队的首要目标,那一定就是这张图!

我还记得在2008年的NeurIPS上展示了我们使用GPU扩展训练神经网络的工作。(顺便说一句,学术界衡量成功的一个标准是,当你的工作被足够广泛地接受时,没有人再引用它。我很高兴当时颇具争议的“GPU应该用于AI”的想法如今已成为一个被广泛接受的“事实”,以至于没人再费心去引用早期推动这一观点的论文了。)

当我创立Google Brain时,我的论点很简单:我想利用公司的巨大计算能力来扩展深度学习。不久之后,我在斯坦福大学用GPU搭建了第一台用于深度学习的超级计算机,因为在斯坦福我可以比在大公司更快地行动。几年后,我在百度的团队展示了,当你扩大模型规模时,其性能在双对数尺度上呈线性提升,这为OpenAI的扩展定律奠定了基础。

展望未来,我确信今天许多人持怀疑态度的一些想法将会被证明是正确的。扩展AI模型已被证明对许多团队有用,并且这一领域仍在持续令人兴奋,但现在我更期待那些未来将被证明更加有价值的即将到来的新想法。

过去一年,我花了很多时间鼓励团队使用AI智能体构建应用,并努力分享最佳实践。我对于明年将变得重要的额外技术有一些假设。我计划在冬季假期期间尝试其中的一些,明年我将有更多分享。但如果你有一个你坚信的想法,只要你能负责任地进行,我鼓励你去追求它!

感谢阅读,如果这篇文章对你有所帮助,欢迎关注算法工程笔记微信公众号!