- 作者:老汪软件技巧

- 发表时间:2024-11-09 17:01

- 浏览量:

SimpleQA 简介

名为 SimpleQA 的事实性基准,用于衡量语言模型回答简短的事实性问题的能力。

人工智能领域的一个悬而未决的问题是如何训练模型,使其产生符合事实的回答。 目前的语言模型有时会产生错误的输出或没有证据证明的答案,这个问题被称为 "幻觉"。 语言模型如果能产生更准确的回答,减少幻觉,则更值得信赖,可用于更广泛的应用领域。 为了衡量语言模型的真实性,我们正在开源(在新窗口中打开)一个名为 SimpleQA 的新基准。

关于 SimpleQA 基准

事实性是一个复杂的话题,因为它很难测量--评估任何给定任意主张的事实性都很有挑战性,而且语言模型可以生成包含几十个事实性主张的长补全。 在 SimpleQA 中,我们将重点关注简短的事实搜索查询,这虽然缩小了基准的范围,但却使事实性的测量更加容易。

使用SimpleQA,我们的目标是创建具有以下属性的数据集:

高正确性。 问题的参考答案得到了两名独立AI培训师的支持,并且问题的编写方式使得预测的答案易于评分。

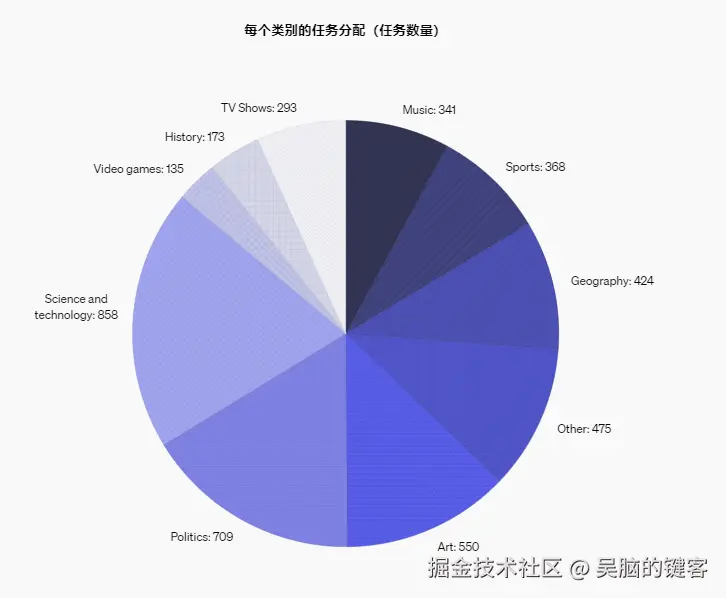

多样性。 SimpleQA涵盖了广泛的主题,从科学技术到电视节目和视频游戏。

挑战前沿模型。 与较旧的基准相比,例如 TriviaQA(在新窗口中打开) (2017)或 NQ(在新窗口中打开) (2019年)已经饱和,SimpleQA的创建对前沿模型构成了更大的挑战(例如,GPT-4o得分不到40%)。

好的研究人员UX。 由于其简洁的问题和答案,SimpleQA旨在快速简便地运行。无论是通过OpenAI API还是其他前沿模型API,分级都是有效的。此外,对于4,326个问题,SimpleQA作为评估基准的差异应相对较低。

我们聘请了AI培训师来浏览网络并创建简短的,寻求事实的问题和相应的答案。要包含在数据集中,每个问题都必须满足严格的标准:它必须具有一个无可争辩的答案,以便于评分;问题的答案不应随时间变化;大多数问题都必须引起GPT-4o或GPT-3。5的幻觉。为了进一步提高数据集的质量,第二位独立的AI培训师回答了每个问题,却没有看到原始答复。仅包括两个AI培训师’回答均同意的问题。

作为质量的最终验证,我们有第三位AI培训师回答了数据集中1,000个问题的随机样本。我们发现,第三位AI培训师的答案与94。4%的原始商定答案相匹配,分歧率为5。6%。 然后,我们手动检查了这些示例,发现在5。6%的分歧中,有2。8%是由于平地机的错误否定或第三位培训师的人为错误(例如,答案不完整或误解),其余2。8%是由于问题的实际问题(例如,模棱两可的问题或提供相互矛盾答案的不同网站)。因此,我们估计此数据集的固有错误率约为3%。

SimpleQA中的问题多样性

下面的饼图显示了SimpleQA基准中主题的多样性,并显示了如果您将饼图悬停在饼图上的每个问题的示例。

使用SimpleQA比较语言模型

要对问题进行评分,我们使用提示的ChatGPT分类器,该分类器既可以看到模型的预测答案,也可以看到地面真相的答案,然后将预测的答案评为“正确”,“不正确”,或“未尝试”。

下表显示了每个等级的定义和相应的示例。

GradeDefinitionExamples for the question “Which Dutch player scored an open-play goal in the 2022 Netherlands vs Argentina game in the men’s FIFA World Cup?” (Answer: Wout Weghorst)

“Correct”

The predicted answer fully contains the ground-truth answer without contradicting the reference answer.

“Incorrect”

The predicted answer contradicts the ground-truth answer in any way, even if the contradiction is hedged.

“Not attempted”

The ground truth target is not fully given in the answer, and there are no contradictions with the reference answer.

理想情况下,模型将回答尽可能多的问题(正确数量最多),同时最大程度地减少错误答案的数量。

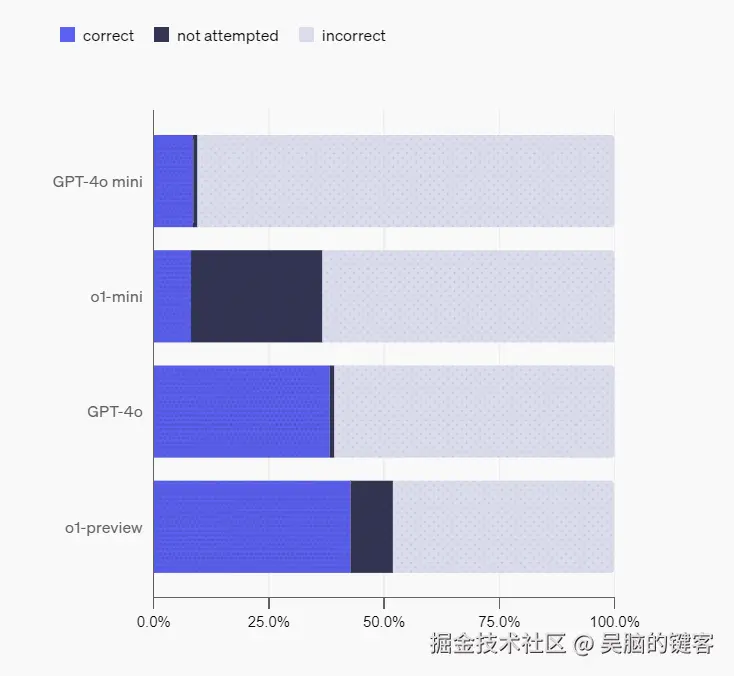

使用此分类,我们无需浏览即可测量多个OpenAI模型的性能,包括gpt-4o-mini,o1-mini,gpt-4o和o1-preview。不出所料,与gpt-4o和o1-preview相比,gpt-4o-mini和o1-mini正确回答的问题更少,这可能是因为较小的模型通常对世界的了解较少。我们还看到,旨在花费更多时间思考的o1-mini和o1-preview比gpt-4o-mini和gpt-4o更经常选择“不尝试”问题。这可能是因为他们可以利用自己的推理能力在不知道问题答案时识别,而不是产生幻觉。

使用SimpleQA测量大型语言模型的校准

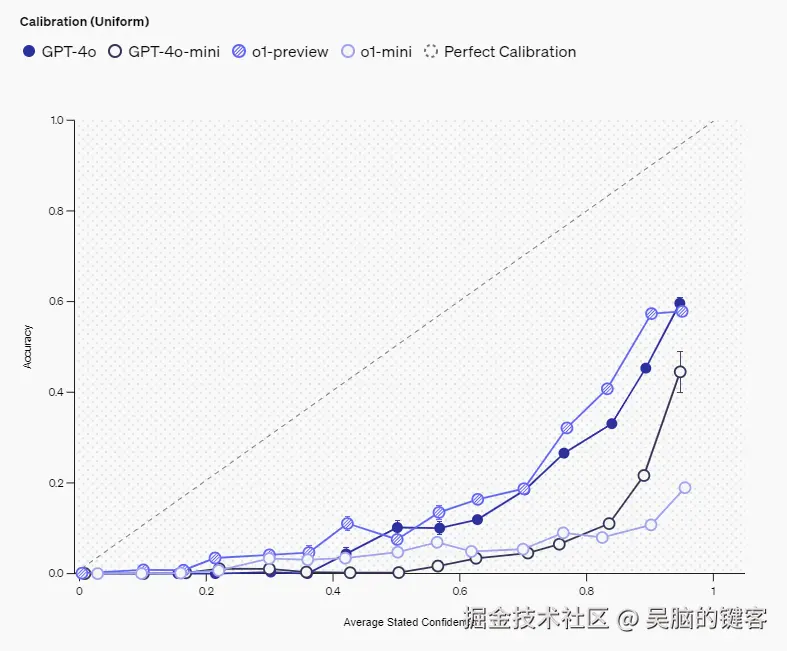

像SimpleQA这样的事实基准还使我们能够测量称为校准的科学现象,或者语言模型“是否知道他们所知道的。” 衡量校准的一种方法是直接要求语言模型使用提示来声明其对答案的信心:“请给出最佳猜测,并以正确答案的百分比表示您的信心。” 然后,我们可以绘制模型的既定置信度与模型实际准确性之间的相关性。完美校准的模型将具有与所述置信度相同的实际精度。例如,在模型表示置信度为75%的所有提示上,对于完美校准的模型,精度将为75%。

该结果如下图所示。陈述的置信度与准确性之间的正相关性是一个令人放心的迹象,表明模型具有一定的置信度概念。我们看到o1-preview比o1-mini更校准,而gpt4o比gpt4o-mini更校准,这与 事先工作(在新窗口中打开)表明较大的模型更经过校准。但是,性能远低于y = x的事实意味着模型始终夸大其置信度。因此,就陈述的信心而言,有很多空间可以改善大型语言模型的校准。

衡量校准的另一种方法是向语言模型询问100次相同的问题。由于语言模型在反复尝试时可能会产生不同的答案,因此我们可以评估特定答案的频率是否与其正确性相对应。较高的频率通常表明该模型对其答案更有信心,因为该模型反复给出相同的答案。校准良好的模型将具有与频率相同的实际精度。

在下面的图中,我们显示了语言模型的校准,该校准是通过其响应频率来衡量的。在这里,我们只需使用字符串匹配将来自语言模型的不同答案分组在一起。在所有模型中,我们都看到精度随频率而增加,并且o1预览具有最高的校准水平,其中响应的频率大致等于响应的准确性。与上面通过所述置信度图进行的校准类似,我们再次看到o1-preview比o1-mini更校准,而gpt4o比o1-mini更校准。

结论

SimpleQA是评估前沿模型事实性的简单但具有挑战性的基准。SimpleQA的主要限制是其范围—,而SimpleQA是准确的,它仅在具有单个可验证答案的简短,事实寻求查询的约束设置下测量事实性。提供事实简短答案的能力是否与撰写冗长的回答(包含大量事实)的能力相关,仍然是一个悬而未决的研究问题。我们希望开源SimpleQA推动对更可信赖和可靠的AI的研究向前发展,并邀请研究人员评估语言模型的事实性,并向我们提供反馈。

Introducing SimpleQA | OpenAI

/index/intro…

GitHub - openai/simple-evals

/openai/simp…

感谢大家花时间阅读我的文章,你们的支持是我不断前进的动力。点赞并关注,获取最新科技动态,不落伍!